「ゲームエフェクト制作へのAI活用」アーカイブ動画

マネジメントとエフェクトデザイナーを兼任

——これまでのキャリアや現在の仕事内容も含めて、簡単に自己紹介をお願いします。

前職はWeb系の会社で、FlashデベロッパーやWebディレクターなどを担当していました。ActionScript 3.0を使った2Dモーション制作から営業や広告の提案まで、多彩な業務に携わっていましたね。

2013年にサイバーエージェントグループがスマートフォン分野に舵を切り始めたのを見て、2Dアニメーションのマネージャーとして中途入社しました。2015年ごろに3Dゲームの開発が始まったのを機に、自分から手を挙げてまだメンバーが少なかったエフェクトデザイナーになりました。

——現在はエフェクトデザイナーがメインの仕事になるのでしょうか。

マネジメントと半々くらいですね。新規プロジェクトの始動時にクオリティの基準と仕様を策定し、チームメンバーをアサインして量産体制を整えたらまた別の新規プロジェクトのチームに移動するようなイメージです。

弊社のゲーム・エンターテイメント事業部(SGE)は子会社それぞれでゲーム開発を行う「子会社制」をとっているため、プロジェクトごとにプロデューサーが持つマネジメント権限が強く、私の負担は大きくありません。そのおかげでエフェクトデザイナーと兼務できている状況ですね。

AIを使わない従来の制作フロー

——生成AIを利用したエフェクト制作について伺う前に、AIを使わない従来の制作フローについてお聞きします。まず、使用しているツールを教えてください。

基本はUnityで、サイバーエージェントが開発した「NOVA Shader」を使用してエフェクトを作っています。エフェクトのベースとなるデータはEmberGenを主に採用しています。サンプルとして用意されているエフェクトが多いため、重宝しています。

ほかに使っているのは、PhotoshopとFilter Forge。連番テクスチャの書き出しにはAfter Effectsを使用しています。

——制作するエフェクトは大きくどのような分類がありますか?

「キャラアニメーションに紐づくエフェクト」「プロップに関するエフェクト」「エンバイロメントに紐づくエフェクト」の3つに分けられますね。そのほか、映像用のエフェクトを作ることもあります。

——全体の開発フローにおいて、エフェクト制作はどの段階から開始されるのでしょうか。

プロジェクトによって変わりますが、本来はプロジェクトの最初からエフェクトデザイナーが参加しているのが理想です。私が担当した『FINAL FANTASY VII EVER CRISIS』は開発の初期段階から入れたため、早いうちにエフェクトの仕様策定ができていました。

量産期においてはモーションチームが制作したキャラクターモーションに合わせてエフェクトをつけることが多く、作業フロー的には後段の工程になりやすいです。モーションを待っている間、回復エフェクトなどモーションに依らないエフェクトを並行して制作することで、効率化を図っています。

——実際の制作では「仕様に応じたテクスチャを加工した画像を元データとしてUnityへインポートし、その後はUnityで制作を進める」という流れで業務を行っているのでしょうか?

そうですね。タイトルによってフォトリアル調やセルルック調など見た目上の特色はありますが、いずれの場合もNOVA Shaderを使って制作しています。

エフェクトの中間コマをAIが生成。業務効率化を実現する

——従来のフローにAIを導入して効率化するアイデアのひとつとして「中間コマをAIに生成させる」というアイデアがありました。

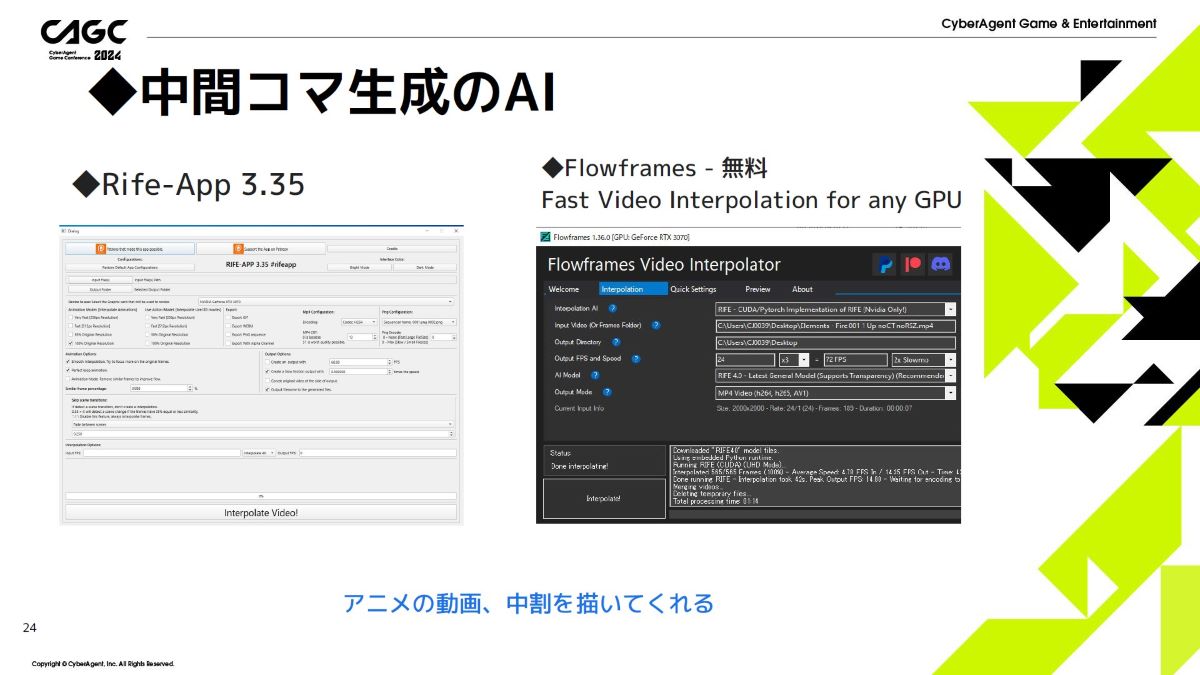

やはり、AIによる中間コマ生成は効果的だと思います。手書きで16コマ描かなくてはいけなかった元データが、4~6コマ描けば成立するようになりますからね。

——単純計算で4倍の高速化が実現する可能性があるというのは大きな効果ですね。

エフェクトの種類に応じて、効率化の度合いは変化します。例えば、フォトリアルなエフェクトであればEmbergenなどの制作ツールが充実しているため、エフェクト用の元データを作るのは難しくありません。

一方で、デフォルメした表現が必要となるアニメ調テクスチャは、いまだに手描きの方が高いクオリティを出すことができます。ただ、エフェクトは用意すべきテクスチャ枚数が多く、外注しなければ用意できないほどの技量が求められるものもあります。イラストレーターが描いたものからAIが中割りを描いてくれるようになれば、大きな工数削減に繋がるでしょう。

以前のセッションでは、EmberGenで出力したリアルなエフェクトを、生成AI「Stable Diffusion」でポーズを指定して画像を生成できる「ControlNet」機能を使ってアニメ調に変換する例を紹介しました。中割りの生成に対しても同様にアニメ調への変換ができるようになると、更にコストが削減できると考えています。今はまだ難しいですが、ツールもだいぶ良くなってきたため、もしかすると半年程度で実現できるのではないでしょうか。

セッションでは、EmberGenで作成した爆発のエフェクトをStable Diffusionでアニメ調へ変換する事例が紹介された

「Stable Diffusion」「Runway Gen-2」など、各AIツールを使った所感

——セッションで紹介された事例に行き着くまでにはどのような試行錯誤があったのでしょうか?

そもそも、AIの検証には莫大な時間がかかります。プロンプトを何度書き直しても思ったとおりにならず、生成にも一定の時間が掛かるため、一定以上の工数は掛かってしまいます。セッションで紹介した、EmberGenによるリアルなエフェクトをアニメに変換する事例においても、何度も試行錯誤し、数えきれないほどプロンプトを書き直しました。

セッションではStable Diffusion以外にもいくつか生成AIを紹介しましたが、その何倍ものツールを試しましたね。

——それはかなりの労力ですね。改めて、手ごたえがあったAIツールの特徴や違いを詳しく教えていただけますか?

「Stable Diffusion」はControlNetを使って形状を指定できるのがよかったですね。先日リリースされた拡張機能「AnimateDiff」にも注目しており、試してみたいと思っています。

「Runway Gen-2」はセルルックを苦手としている印象を受けました。リアルなエフェクトを作るのに特化しているのかもしれません。

Runway Gen-2で画像を元に作成された動画。プロンプトでの補完が必要で不完全な部分があるそう

「Pika」はRunway Gen-2よりセルルックに適しているように感じました。ただ、元の形状を理解して変化させることはうまくできませんでした。

有料ながら日本語で使用できるPikaの使用例。アニメ調からリアルへの変換が長所であるとのこと

——講演では現状まだ「連番のアトラス化に課題が多い」と述べられていましたが、「連番のアトラス化」の課題について詳しく教えていただけますか?

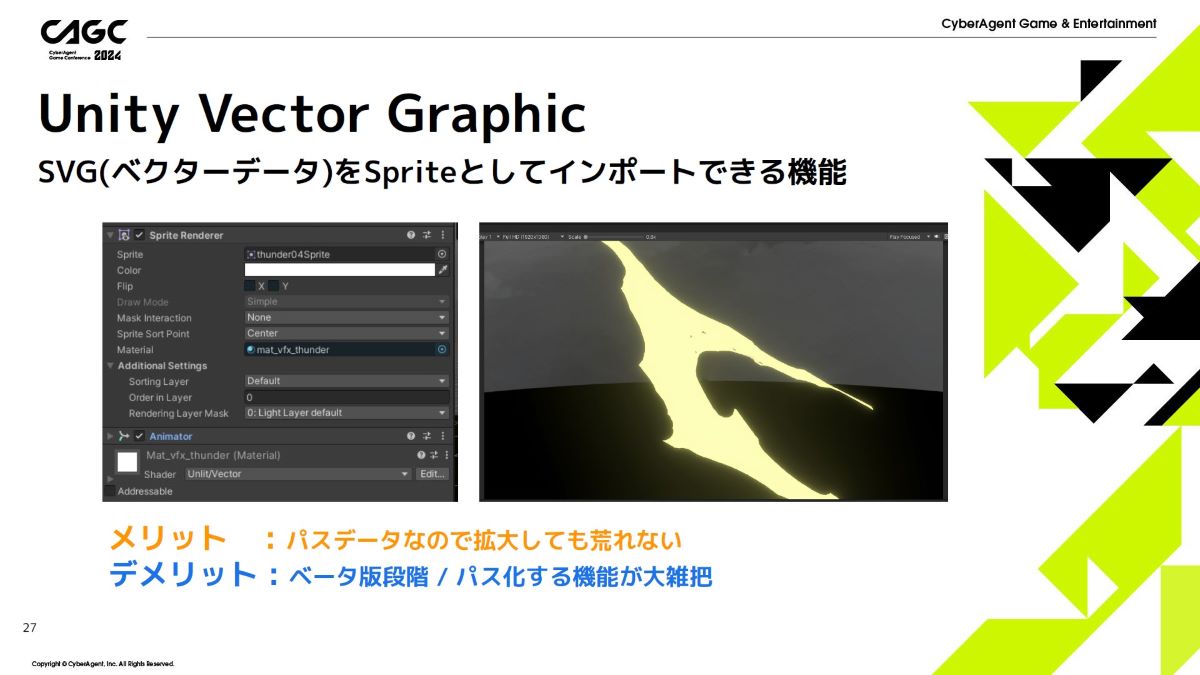

パーティクルに貼り付けるテクスチャを1枚のみにすると形状が変化せず表現の幅が狭いため、クオリティを高めるためには16~32コマの連番画像を使ってアニメーションさせることも多いです。ただ、テクスチャが増えるとメモリの圧迫や描画負荷の上昇につながるため、解像度には制限があります。

2,048 x 2,048ピクセルに描いたとしても、1枚の画像を画面全体に表示させるとジャギーやモアレが発生してしまいます。そこで、形状をベクターパスで表現すれば、描画コストはかかりますが低い解像度に起因する問題が発生しなくなります。これがアトラス化ですね。

UnityでSVGをインポートすればデータが軽く、パスデータであるため拡大しても荒れないメリットがある

連番のアトラス化にはFlashデベロッパー時代によく扱っていた、軽くて使いやすいSVGフォーマットがもう一度使えたら、と期待している面もあります。連番のアトラス化で見られた課題のひとつは、Unityの変換機能が正確ではないことによって穴が空いてしまうことです。そこで、パスをMaya上で平面メッシュに変換し、着色することで正確な結果が得られました。

今後AIで表現したいのは「爆発のフォグ」

——エフェクトの種類によっては、中割りを増やすことで動きが滑らかになり過ぎ、違和感が生じるものもあるように思います。R&Dを進める中で、「AIと相性が良い」「AIが向いている」と感じたエフェクトの表現はありますか?

そのまま使ってよいかは別問題ですが、リアルな炎は現状のPikaで十分な品質のものが作れそうです。形状がハッキリしている「雷」も、生成AIでアニメ風のエフェクトを作りやすい部類だと思います。リアルな雷であれば、After Effectsにデフォルトで搭載されている「稲妻(高度)」がかなり使えますし、途中で形状が変わらないためAIを使う意味は薄いでしょう。

今後は、形状が変化する「爆発のフォグ」がAIで表現できるようになると良いですね。アニメ調で最も難しいのが、爆発のようなモヤモヤしたフォグです。巻き込んでいくような煙の表現などは、1枚描くだけでも大きな作画コストがかかります。

また、フォグは情報量が多く、キャラクターの後ろで動いていると意図せず視線誘導してしまいます。そのため、視線をキャラクターに向けさせるよう、いかに描き絵を削って情報量を落とすかが重要になってきます。実際、多くの現場で情報量を減らす工夫をしているのではないでしょうか。

——AIが生成したフォグの画像を使う場合、あまり情報量が多いとかえって邪魔になってしまう可能性もあるということですか?

極端に言えばそうですね。とはいえ情報量を削るのは難しくないため、情報量が多い分にはそこまで問題にはならないかと思います。

リアルなエフェクトは現状でもAfter Effectsなどのツールで作れるため、AIの効果が薄いと感じます。その一方でアニメ調のエフェクトや手描きせざるを得ないフォグなどへの活用には期待したいですね。

アニメ調でも破綻なく中割りを生成できた「Rife-App」と「Flowframes」は、「アニメ業界でもコスト削減につながるのでは」と期待が寄せられた

生成AIで業務効率化を強化するための「AIオペレーション室」を設置

——AIの導入について、権利関係やワークフローへの組み込みの際のトラブルについての対処はどのように検討・準備されていますか?

生成AI技術分野においては、ビジネス職を含む全社員の生成AIに関するリテラシー向上に向けた取り組み強化とあわせ、誰もが生成AIを業務で活用できるための環境整備を推進しています。

社員が適切に生成AIを活用できるよう「生成AIガイドライン」で一定のルールを定めているほか、法務との相談窓口も設けています。

セッションでは、生成AIのモデルを適切にブラッシュアップしていくことも、クオリティや安全性の向上につながると指摘された

——AIを用いたR&Dを先行する立場として、どのような環境や条件があれば業界全体にAI活用が広がると考えていますか?

AIを研究することについてはメリットしかないと思っています。ただ、研究には大きく時間がかかるため、業界全体で研究を進めていけると良いと考えています。業界中のみんながAIを試して「あれができた」「これができたよ」と共有しあう世界になれば理想ですね。

セッションの冒頭でも邑上氏は「今回行ったR&Dの成果を、新たなチャレンジや発信につなげてほしい」と述べている

前職のIT業界では、自分が研究したものを世の中に出していく文化が盛んでした。一方で、ゲーム業界は作った技術を大切にして、なかなかオープンにはしない印象を受けました。NOVA Shaderを世の中に公開したのも、もっとゲーム業界にオープンな文化が浸透していくとよいなという気持ちが理由のひとつにあります。そうして大勢でAIの活用を研究することで知見も溜まりますし、AIに対する見方も変わってくるかもしれません。

——ちなみに、現在個人的に注目しているAIやエフェクト関連の技術はありますか?

私がエフェクト関連で期待しているのは、リアルタイム流体シミュレーションツールの「LiquiGen」ですね。水のリアルな表現が手軽に制作できるようになれば、すぐにアニメ調にも応用ができるのではと感じています。

AI全般で言うと、映像からモーションを抽出する技術に注目しています。私たちが必殺技を作る際は、ビデオコンテを使って「カメラワークの外連味が違う」「尺感が違う」と、何回も作り直します。その際、AIを使って完成形に近いキャラクターモーションを出力できれば、より精度の高いビデオコンテを低いコストで制作できます。

今は絵コンテを描いてもらったあとに仮モデルでモーションを作成、そこにエフェクトを当てていくという流れで作業を行っていますが、ビデオコンテを作る時間をAIによって短縮できれば、イテレーションも多く回せるようになると考えています。

AIは「クオリティだけに向き合う時間を増やすためのツール」として扱う

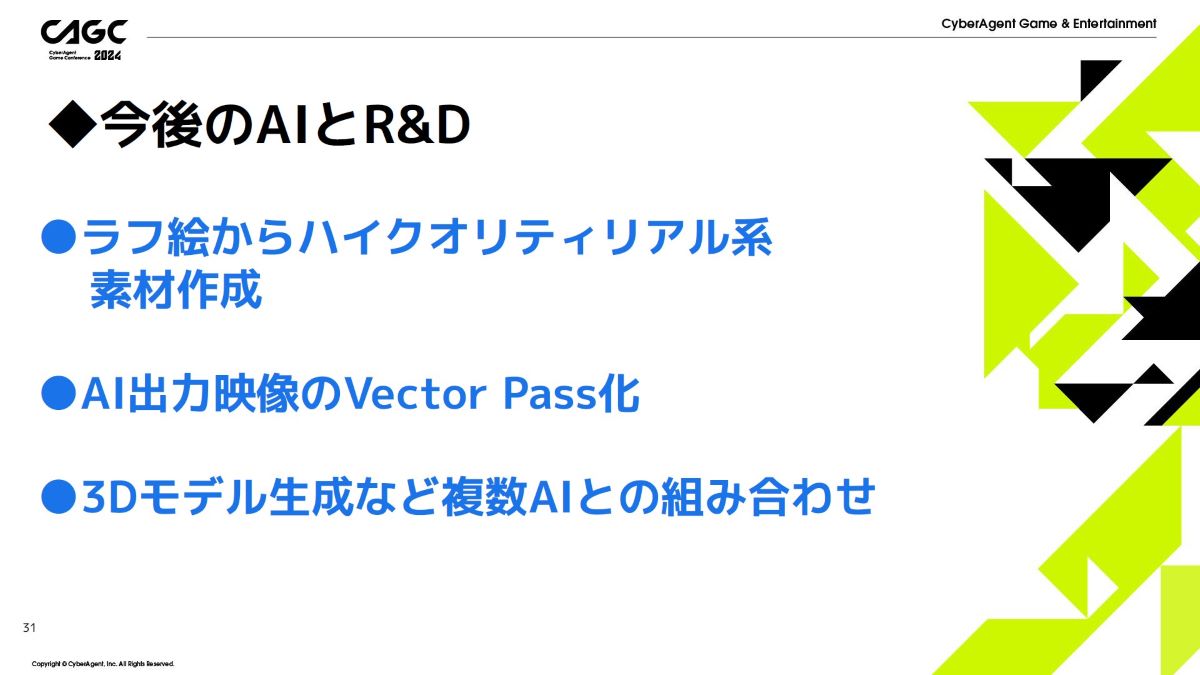

——今後行うR&Dのビジョンを教えていただけますか?

先ほども言った通りビデオコンテ用の3Dモデルとモーションの生成ですね。何パターンか出してモーションを組み、最終的にAIでビデオコンテを作るところまで達成したいと考えています。

セッションでは、今後の展望として複数の工数削減手法が提案された

キャラモデルを差し替えた時、カメラワークがついた時、エフェクトが入った時などで見え方はかなり変わりますし、それを受けて背景の情報量を削るのかなどの相談も行うため、この工程を効率化する余地は大きいのではないかと感じます。

私としては、AIは「自分たちがクオリティだけに向き合う時間を増やすためのツール」として研究が進んでほしいと考えています。プロの方も学生の方も、クリエイティブな時間を充分に使えるようなるための時短ツールとして、ぜひAIを活用していただきたいです。

——今回はエフェクト制作が中心でしたが、この他にもAIを活用してクオリティアップにつなげられているケースなどはありますか?

UIチームがタイトルロゴのアイデア出しにAIを使っているようですね。手で描いていく前に、AIに30案ほどアイデアを出してもらうことで、かなりイテレーションが回せるようになったそうです。

——最後に、クリエイターが今後AIとどう付き合っていくか、お考えをお聞かせいただけますか。

人によって捉え方は異なるでしょうが、私はAIを「イテレーションの高速化を助けてもらうツール」だと考えています。判断や意図を汲んだ修正など、人間にしかできないことはたくさんあります。AIにできることはAIに任せて、よりクオリティの高いゲームをより早く出せるようになると良いと思います。

「ゲームエフェクト制作へのAI活用」CAGC2024公式サイト邑上 貴洋氏 Xアカウント

大阪生まれ大阪育ちのフリーライター。イベントやeスポーツシーンを取材したり懐ゲー回顧記事をコソコソ作ったり、時には大会にキャスターとして出演したりと、ゲーム周りで幅広く活動中。

ゲームとスポーツ観戦を趣味に、日々ゲームをクリアしては「このゲームの何が自分に刺さったんだろう」と考察してはニヤニヤしている。