オリジナルを継承したリメイクへの挑戦

――自己紹介をお願いします。

蟹川: リードサウンドデザイナーとして、効果音制作や組み込みを中心に、カットシーンMA、音声収録ディレクション、空間音響設計、インゲームミックス など幅広く関わっています。

大岡: 「ボム蛇合戦」や「FOX HUNT」の新規楽曲の制作に加え、空間音響や出力・サウンドシステム全般の設計と組み込みを担当 しています。本日はよろしくお願いします。

広瀬: Sound xR Core 」を提供しています。もともとは省庁に勤めておりましたが、いまはヤマハで立体音響の普及に務めております。

(左から)ヤマハ 広瀬 健治氏、コナミデジタルエンタテインメント 大岡 弘明氏、蟹川 俊介氏

――本作は2004年に発売された『METAL GEAR SOLID 3 SNAKE EATER』を原作としたリメイク作品です。どのようなサウンドが目指されたのでしょうか?

蟹川: 本質を変えずに進化させる 」。これが、サウンドに限らず制作チーム全体で共有していた目標です。

グラフィック表現でも、原作の雰囲気を大切にしながら、空間の奥行きや光の反射といった画面全体の情報量やディテールを高めることで、現代的な表現へとアップデートしていました。そのためサウンドに関しても、単純に「当時のものをそのまま使う」というわけにはいきませんでした。オリジナル版の開発当時は、メモリ容量や再生環境にさまざまな制約があり、同じ音を使い回さざるを得ない場面も多かったんです。

今回はそうした制約から解放された現代の環境を前提に、オリジナルの意図を踏襲しつつ、リメイク作品としてふさわしいサウンドへと再設計 することを目指しました。

蟹川: 私たち開発チームはオリジナル作品を心からリスペクトしています 。あの時代において『METAL GEAR SOLID 3 SNAKE EATER』は間違いなく完成された作品でした。

だからこそ今回のリメイクでは「壊す」のではなく、当時の完成度を土台にしながら現代の技術でどこまで体験を拡張できるか 、サウンドチームとして挑戦しました。

開発環境はUE5.2×Wwise。立体音響にはSound xR Coreを選択 ――オリジナル当時からは開発環境や規模も大きく変わっていると思いますが、サウンドの開発規模と使用した環境・ツール、仕様などを教えてください。

蟹川: Sound xR Core 、そして反射や残響にはWwise Spatial Audio などを組み合わせて使用しています。

インゲームSEの制作とMA(Multi Audio:カットシーンに音をつける作業)はPro Toolsで行っています。ゲーム本編は7.1.4chのサラウンド出力に対応しており、ターゲットラウドネスは-20から-24LUFSに設定しました。

大岡:

――タイトルに関わったサウンドチームは何名でしょうか。

蟹川:

大岡:

蟹川:

効果音はほぼ新録。楽曲はオリジナルデータを継承 ――本作のアセットは全て新録したのでしょうか?それとも、オリジナルの継承として、当時のデータを流用する部分も多いのでしょうか。

蟹川:

グラフィックスがすごく立体的なのに、当時のサウンドは圧縮率が高く、どうしても前に張り付いたような音になってしまっていました。結果として距離感が掴みにくかったんです。その時点で「これは全部作り直そう」という判断になりましたね。

――確かに、かなり想像できます。ただ、アセット差し替えの良いガイドにはなりそうですね。

蟹川:

今回のサウンドリメイクは、単純にアセットを差し替えるのではなく、オリジナルのサウンド表現や設計思想を“コア”として捉えつつ、現代のグラフィック表現に見合う密度や当時は実現できなかった表現を丁寧に積み重ねていくというアプローチでした。

その考え方が分かりやすく表れているのが、物理マテリアルを軸にしたサウンドデザイン です。

本作では60種類以上の物理マテリアルが定義されており、足音や跳弾音、薬莢の落下音、ナイフのヒット音など、プレイヤー周囲で発生する接触音をマテリアルごとにすべて作り分けています 。例えば薬莢の音ひとつをとっても、落下時と転がり音を分けたうえで、銃弾の種類や各物理マテリアルごとの違いによって鳴り方を変えています。

これは単に音のバリエーションを増やすためではなく、映像の情報量や空間の奥行きが増したぶん、音も同じ粒度と密度で空間を支える必要があるという考え方からきています。

大岡:

蟹川:

どんな材質の場所に立っているのか、周囲のどこで何が起きているのか。そうした情報を音からも自然に受け取れるようにすることで、プレイヤー自身が状況を判断し、次の行動を選ぶ助けになるような音作りを目指しています。

単なる演出として音を足すのではなく、プレイヤーの体験や判断を支える要素としてサウンドをどう機能させるか。その答えとしてこのような作り込みに至ったということですね。

――組み合わせ爆発が起きていそうで、話を聞いているだけでも物量の多さにめまいがしそうです。ということは、実装されたサウンドアセットについてはほぼ全て新録になっているということでしょうか。

大岡:

一方で、新規制作・新規録音した楽曲もあります。 シンシア・ハレル氏による歌唱を新たに収録した「Snake Eater Δ Version」をはじめ、 LA・ベルリン・東京の3拠点でオーケストラ収録を行い、Dolby Atmosミックスを実施しました。インゲームでは、Dolby Atmosミックスしたものを7.1.4chにダウンミックスして再生しています。

蟹川:

あくまで『メタルギア』のサウンドとして成立させること、そしてかつて遊んでくれたユーザーが再びプレイしたときにも、できるだけ違和感の少ない体験になることを目指しました。

「潜入体験」のため、サウンドの位置関係を正確に伝えることが重要に

――本作では「立体的なサウンド表現」がプロモーションのキーワードに含まれていましたが、なぜ立体音響も含めたサウンドの開発にこだわったのでしょうか。

蟹川:

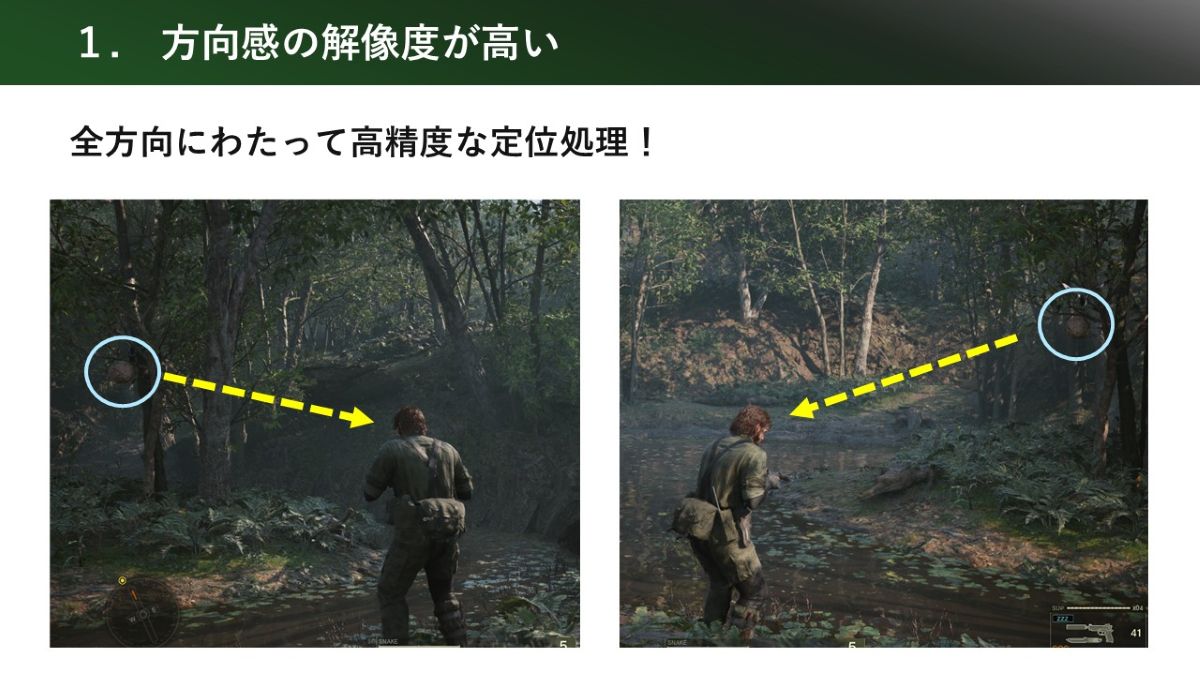

また、本作では新たに「三人称視点モード」が追加されており、それに伴ってサウンドもよりプレイヤーキャラクターを中心とした音像を構築する必要がありました 。敵や環境音が「どの方向に」「どのくらいの距離感で」存在しているのか。そうした空間的な位置関係や方向感を音によって正確に分かりやすく伝えることが、私たちサウンドチームにとって重要なミッションだったんです。

――そこで、先ほどお話に上がった反射や残響、遮蔽などの要素に加え、立体音響も導入したと。実装工数や負荷なども上がるのではと思いますが、それを上回るメリットがあったのでしょうか?

蟹川: Sound xR Coreであれば、実装や検証の工数が増えるコストを十分に上回るメリットがあると判断しました 。

まず体験面について、音の方向や距離感を全方向にわたりきわめて細かく表現できる こと。特に上下方向や後方の定位が、直感的に分かりやすくなります。敵の存在や周囲の状況を音で判断する本作のような潜入アクションでは、体験の質を大きく底上げしてくれる要素 でした。

蟹川:

広瀬: Unity、UE5、Wwise向けプラグインとして提供されているほか、CRI ADXにはヘッドホン立体音響として標準搭載 されています。

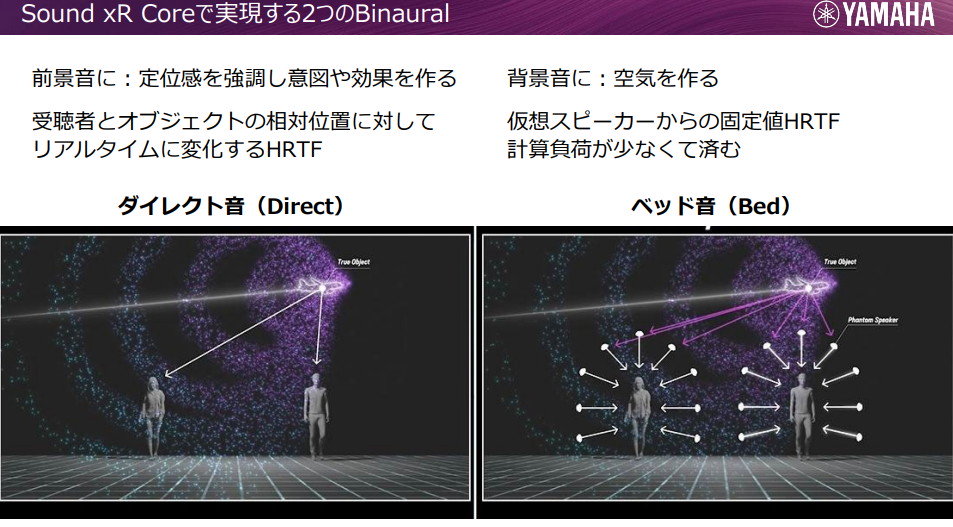

ヤマハとしては、ヘッドホンで聴いたときに「頭の中で鳴っている音」を、いかに頭の外に感じさせるかという課題からスタートしています。人の耳は全天球的なセンサーのようなもので、左右の耳に届く音の時間差や位相差を手がかりに、音の位置を認識しています。

その知覚の仕組みを数式としてモデル化したものが、いわゆる頭部伝達関数(HRTF)です。モノラルの音源に対して波形変換モデルを畳み込むことで、実際には存在しない位置から音が聴こえるような定位感を擬似的に再現できます。

蟹川:

R&Dの段階では、簡易的なレベルに音源を配置して楽曲や銃声を鳴らしながらカメラを回し、後方や上下方向の定位感を確認していました。その時点で、サウンドデザイナーの感覚として「これは行ける」という手応えがありましたね。

大岡:

個人的にはマルチプラットフォーム対応が一番大きかったですね。それまでは、PlayStation 5ではTempest 3Dオーディオ、 XboxではDolby Atmos for Headphonesといったように、 プラットフォームごとに特性の異なるバイノーラルレンダラーがビルトインされていました。

そのため出音の担保という観点で、出力周りをWwise上でどう組むかに苦慮していましたが、Sound xR Coreを導入したことで、全プラットフォームでバイノーラルレンダラーを統一 できるようになりました。結果として、「このプラットフォームでは問題ないが、あのプラットフォームでは問題がある」といったトラブルが一気に解消されたんです。 このレンダラーの統一は実装面で大きな前進でしたね。

Wwise上でSound xR Core単体の処理負荷を計測したところ、 CPU使用率の増加は約2~3%程度にとどまっていたという。 そのパフォーマンスに加え、音質面の向上やサウンドデザインを一元化できる点も評価され、 導入に踏み切ったそうだ

「Sound xR Core」製品紹介ページ ――定位感や音質、負荷などを比較した結果、Sound xR Coreを選ばれたということですね。実際に組み込んでみて、サウンド制作の進め方や自由度という点ではどのような変化がありましたか?

蟹川: 一度組み込んでしまえば、サウンドデザイナー側で落とし所を調整できる 」ようになったことですね。

Sound xR Coreは、ゲーム内のパラメータやステートに紐づけた制御や、ダイレクト処理する音の優先度設定など、オーディオミドルウェア側で調整できる余地が非常に多いんです。そのおかげで「このシーンでは発音数が増えて処理負荷が高くなっているから、この音の鳴らし方を整理しよう」とか「この音は体験的に重要だから、優先度を上げて確実に聴かせよう」といった判断や調整をサウンドデザイナー自身の手元で行えるようになりました。

結果として、プログラマーへの負担を掛けずに意図した音に作り込める。そこが、制作の進め方や自由度という意味で非常に大きな変化だったと感じています。

バイノーラル化によるメリット・デメリット

――Sound xR Coreのようなバイノーラル化において、原音忠実性はよく話題に上がります。定位が分かりやすくなることと、音質面のバランスはどのように取っていきましたか?

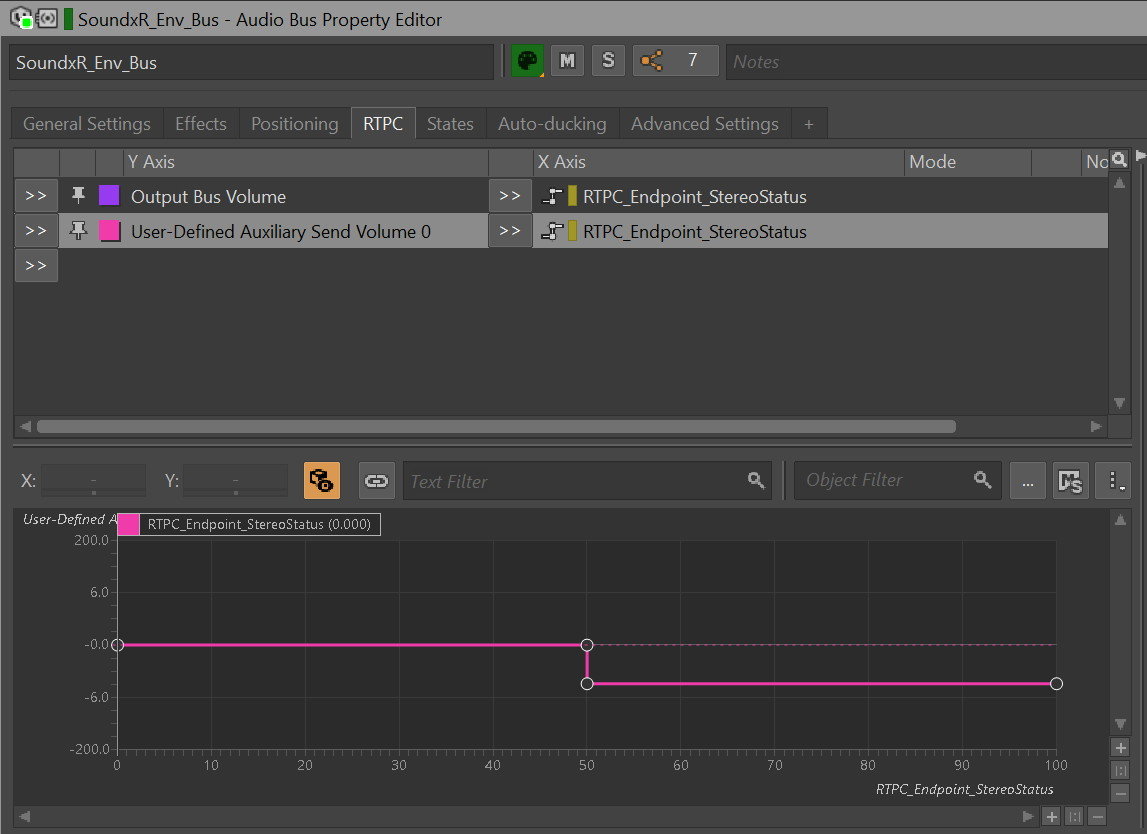

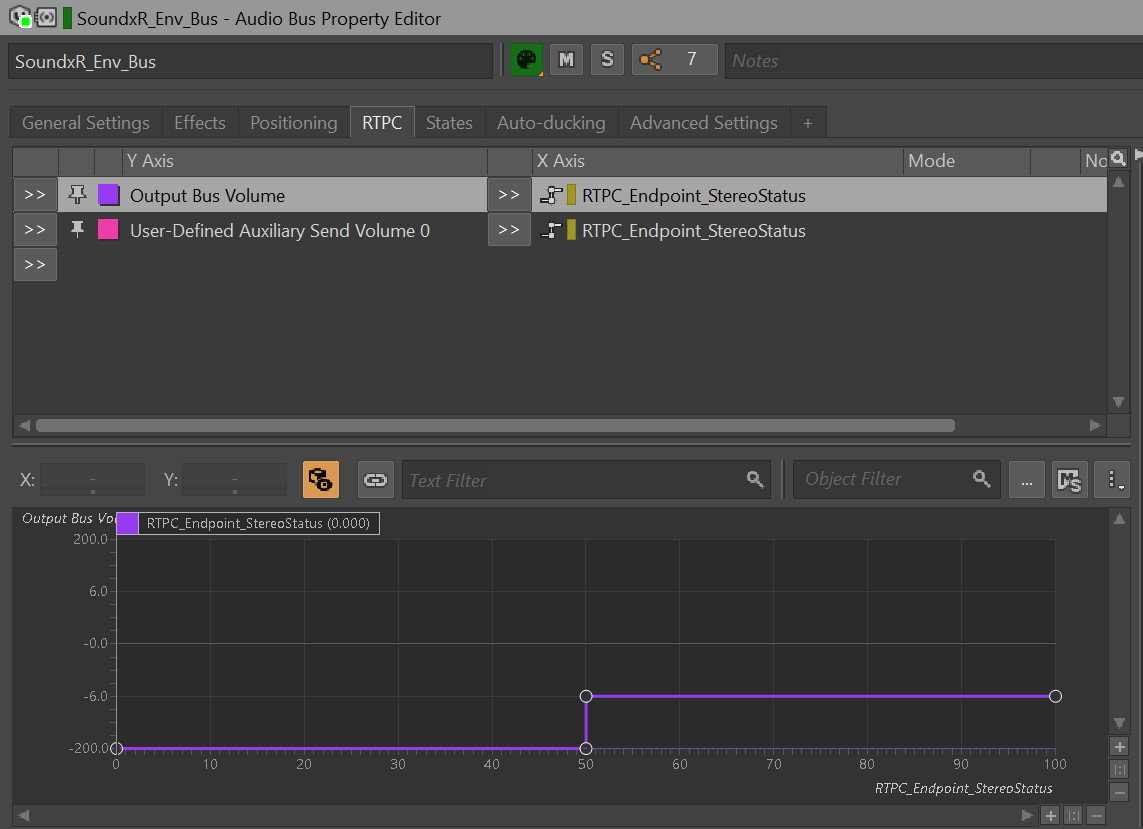

大岡:

さらに本作では、定位優先のPCNタイプ(※)を選択していたため、そこからさらに音が変わってしまい、結果的にサウンドデザイナーが意図しない音に変わる、デザインが変わってしまうという課題が発生しました。デモを用意したので、聴いてみてください。

※Sound xR Coreで選択可能なHRTFタイプのひとつ。PCNは定位感を最優先としている。他にも、音質の変化の少なさを優先するTC4などがある。オブジェクトごとに設定が可能

大岡:

大岡:

定位感最優先の設定にした「Sound xR Coreの出力音」。定位感は強く感じられるが、原音からは音色が変化している

蟹川:

大岡氏が提案した運用方針。両者の音をミックスすることで、原音の音色を保ったまま定位感を付加できるように

大岡: もともとON/OFFしかなかったWwiseのバス構成を、DRY/WET( ※)を混ぜられるように変更した んです。「割と簡単に実験できますけど、どうですか?」と提案して、いざ試したら音色の再現性の担保をしつつ、方向感も感じられる結果になったので採用となりました。

※DRYはエフェクトが掛かっていない原音、WETはエフェクトが完全に掛かった処理後の音を指す。これらを混ぜて(ミックスして)再生している。

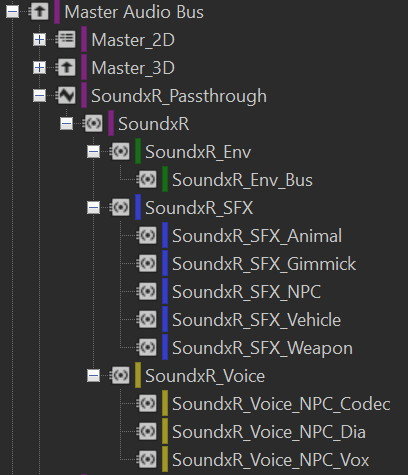

本作のWwiseのバス構成。Envは方向感が大切な環境音、Gimmickはステージギミック、Weaponは銃声など、カテゴリごとに分類されている。各カテゴリごとにDRY/WETのミックスができるようになっている

――DRY/WETでの調整は、サウンドデザイナーにとっても納得感のある解決策だと感じます。アセットにもよると思いますが、どのくらいの割合でミックスしていますか?

蟹川:

大岡:

バイノーラル化は銀の弾丸ではない。使うべきシチュエーションを適切に選ぶ ――原音の忠実性はルーティングの工夫で担保できたとのことですが、実際の運用面で注意した点はありますか?

大岡:

蟹川:

広瀬:

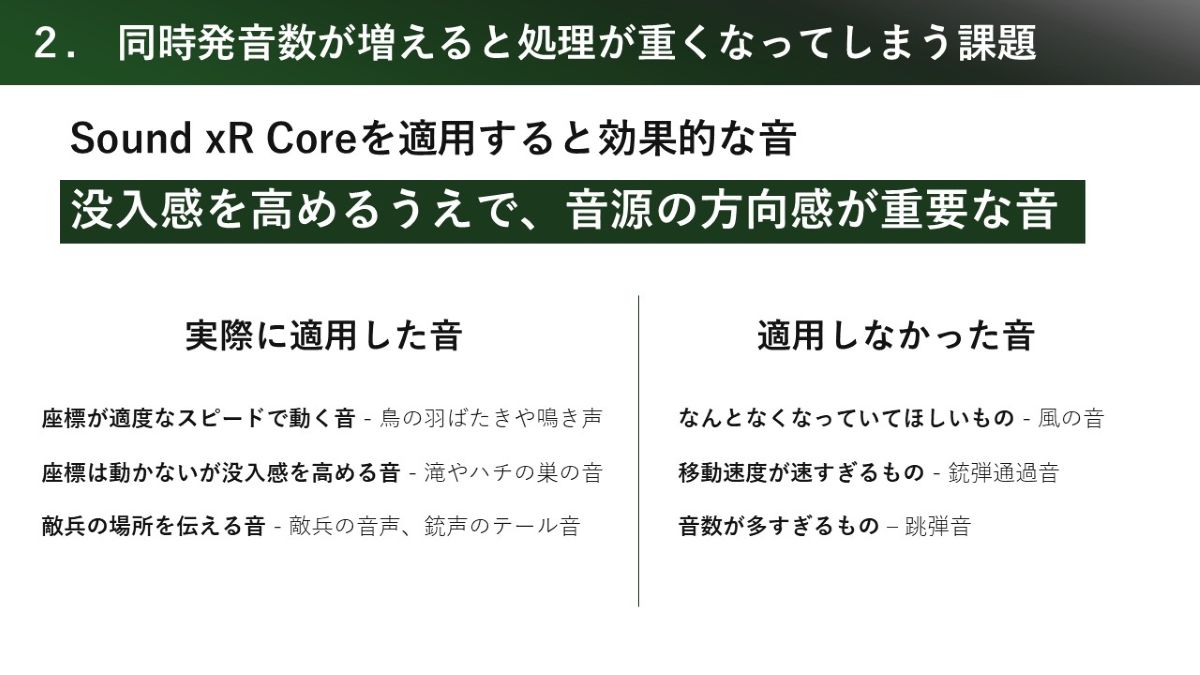

ダイレクト音は同時に多くの計算を行うため、再生可能発音数が設定されています。上限を越えた分はベッド音のレンダリングに回されます。Sound xR Coreには、使うべき音、使わなくても良い音が必ずあります。そこはサウンドデザイナーのデザイン哲学によって選定していただきたい部分です。

――つまり、通常のサウンドリストとは別に、どの音でSound xR Coreを有効化するかを管理する必要が出てきたということですね。実際の運用としては、どのような形で対応したのでしょうか。

蟹川: Sound xR Coreを適用する音については、通常のサウンドリストとは別に専用の管理リストを用意して、「どの音に適用するか」を整理 しました。いわば、適用方針をまとめた計画書のようなものですね。

そのうえで、実際の適用作業は、インゲームミックスの調整と並行して進めていく形を取りました。

今回は全体のインゲームミックスも含めて私が担当していたので、どの音に適用するかの選定から最終的な調整まで、既存のワークフローの中に自然に組み込めた感じですね。そのため、作業としては特に大きな負担には感じませんでした。

それよりも、最終的にプレイヤーに届ける体験が良くなるのであれば、この手間はかけるべきだと思いましたね。

――没入感を高める上で重要な音とは、具体的にどのようなサウンドでしょうか。

蟹川:

例えば、銃の跳弾や弾の通過音にも効果自体はありますが、発音が非常に短い上に短時間で発音が重なりやすいため、そのぶん処理負荷もかさみます。その割に、体感として得られる効果はそこまで高くなかったんですよ。であれば、そういった音にかかる処理負荷を抑えて、より効果の高い音にリソースを回したほうが良いという考え方で整理していきました。

逆に、座標が適度なスピードで動く音、例えば鳥の羽ばたき音や鳴き声のようなものは相性が良かったですね。 また本作はステルスゲームなので、 何よりも重要な敵兵の位置を伝える音―― 敵兵の音声や、銃声のテール音などには積極的に適用しています。

どんな環境でも、サウンドデザイナーが意図したデザインの空間表現を届けたい

――マルチプラットフォーム対応について、もう少し詳しく教えてください。出力先のプラットフォームを問わず、Sound xR Coreで作り込んだ音が出力されることがメリットだと思いますが、具体的にはどのように実装したのでしょうか。

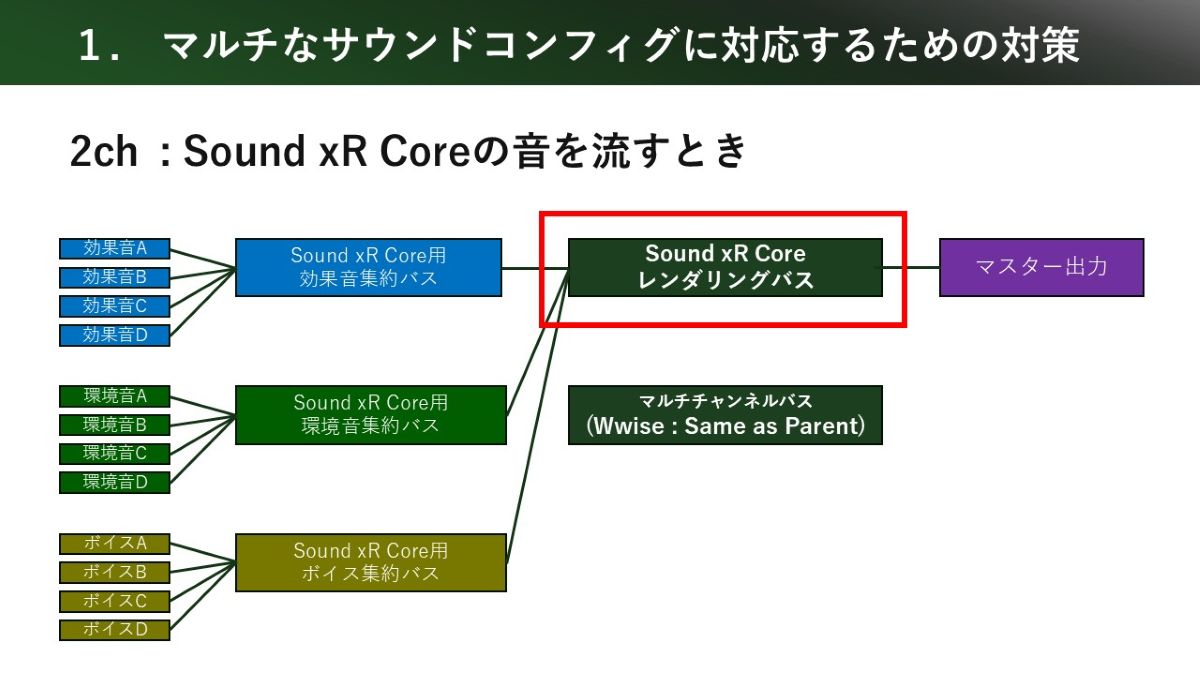

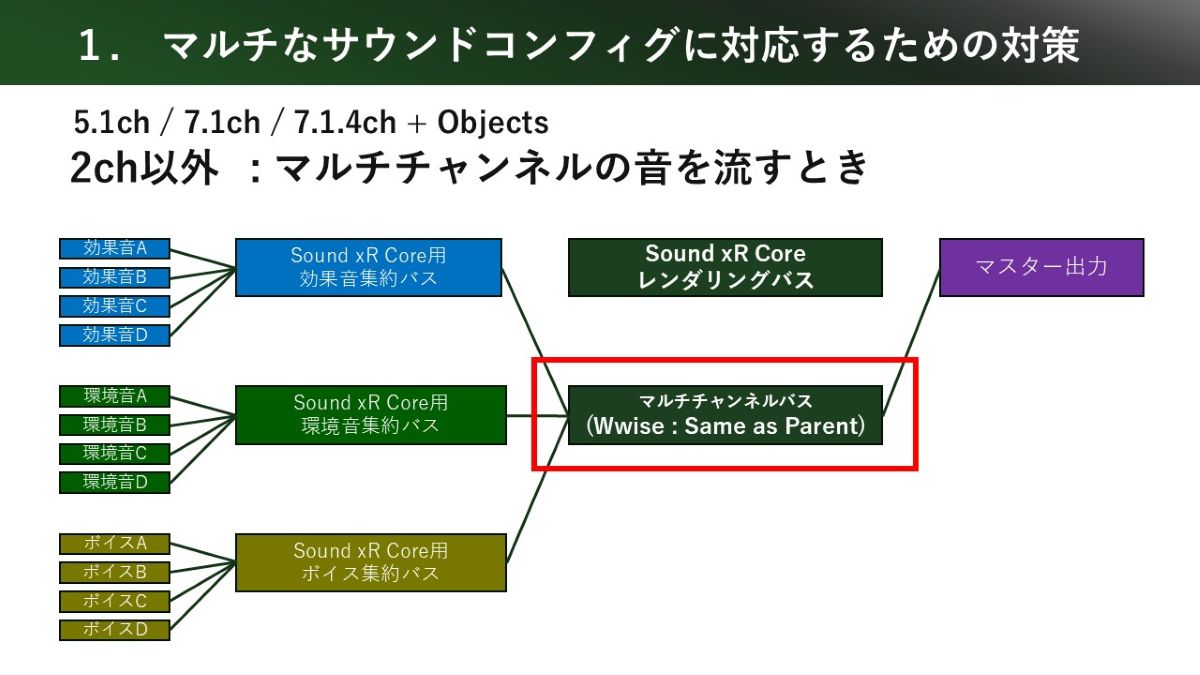

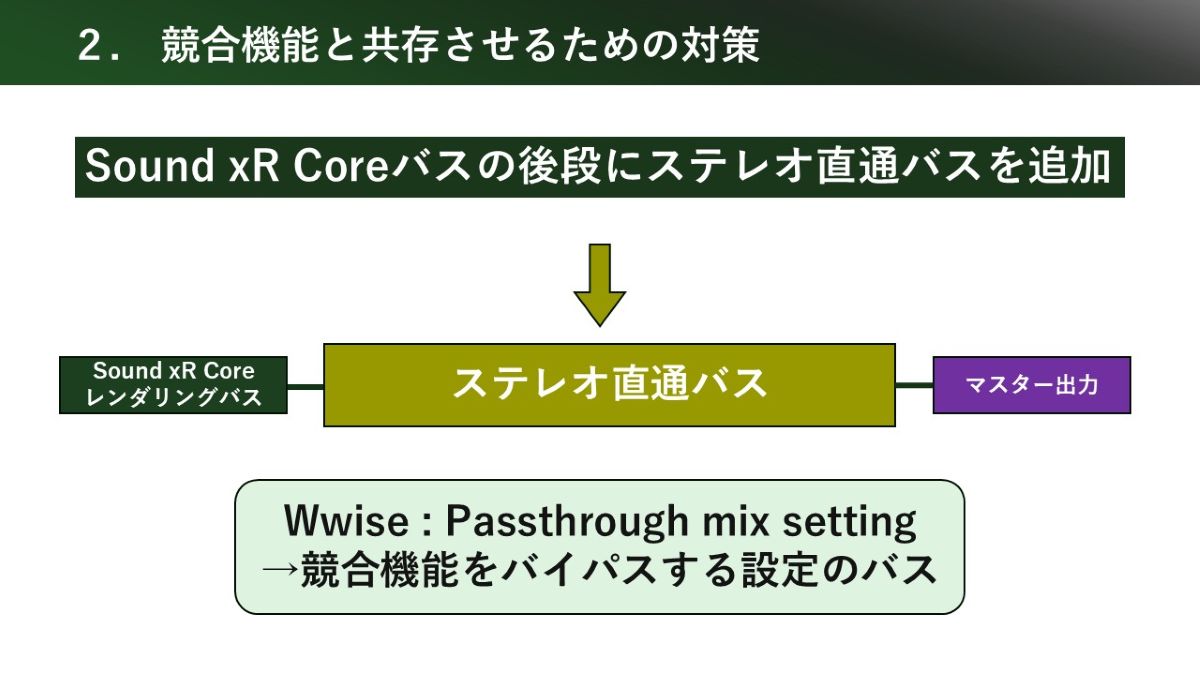

大岡:

画面左側、効果音A、B、C、Dなど、ゲーム内で再生される効果音が、Sound xR Core専用の効果音集約バスにまとめられる。同様に、環境音、ボイスについても専用の集約バスに音がまとまっている。ここからSound xR Coreレンダリングバスに必要な音を送り、バイノーラル化ののちマスターに流れるルーティング

一方で、5.1ch、7.1chなど最終アウトプットが2チャンネル以外の環境では、マルチチャンネルの音を鳴らす必要がある。各カテゴリーの音が集約バスにまとめられるところまでは一緒だが、そこからSound xR Coreレンダリングバスには送らずに、マルチチャンネルバス(Same as parent)バスに音を送り、そこからマスターに出力している

蟹川:

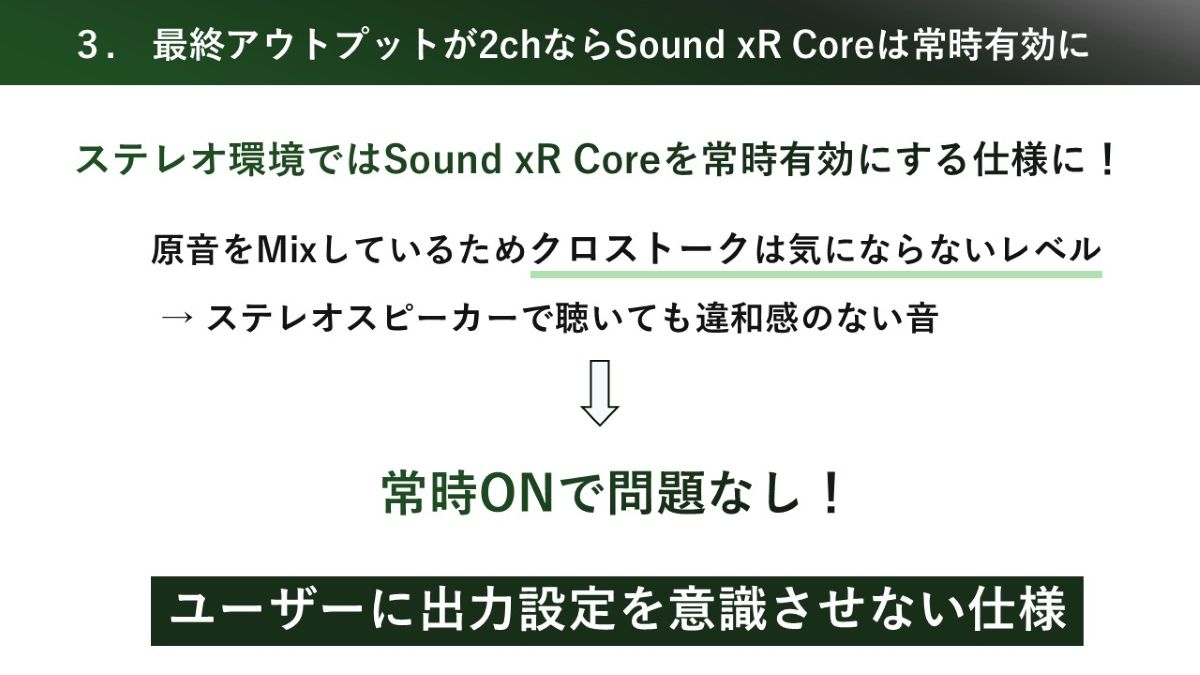

というのも、ステレオ環境にはヘッドホンだけでなく、ステレオスピーカーも含まれます。そこで「スピーカーで聴くときはONなのか、OFFなのか」といった判断をユーザーに委ねると、体験としてはノイズになってしまいます。そのため、エンドポイントを見て自動的に切り替わる形を選びました。

この設計判断を行ううえでの前提として、先ほどご紹介した原音をMixする運用があります。そもそものSound xR CoreのMix量を抑えているので、ステレオスピーカー環境でもクロストークは、聴感上気にならないレベルに収まっていました。

この手応えがあったからこそ、ヘッドホンかスピーカーかを意識させることなく成立させられると判断して「2chであれば常にSound xR Coreを有効にする」という設計を選択しました。

――Sound xR Coreとその他の立体音響ソリューション、例えばPlayStation 5標準搭載のTempest 3Dオーディオは競合関係にあり、いずれも有効の場合は“フィルターの二度掛け”になると思いますが、どのように対応していますか?

大岡:

この対策と、先ほど説明したバス切替の仕組みを組み込むことで、最終アウトプットが2chであれば、どの環境でも自動的に、サウンドデザイナーが意図した音や空間表現をそのまま届けられるようになりました 。

エンドポイントが2chの場合のみSound xR Coreの出力が有効化するように、WwiseのRTPCで制御している

――ありがとうございます。最後に、記事を読んでSound xR Coreに興味を持った方に向けてメッセージをお願いします。

蟹川:

だからこそ、サウンドデザイナーが「どう聴かせたいか」に責任を持ち、最後まで音作りを完結させられる点に、Sound xR Coreならではの大きな魅力と価値がある と感じています。

今回の事例が「こういう使い方もある」という一つのヒントとして今後の立体音響デザインや技術検証の一助になれば嬉しいですね。私たち自身も引き続き検証を重ねながら、より良い使い方を模索していきたいと思っています。

大岡:

今後は、TC系とPCN系(Sound xR Coreで選択できるHRTFの種類)でバスを分けたり、負荷軽減のためにTempest 3Dオーディオを併用する構成を作ったりと、より柔軟な空間表現を目指して研究を行いたいです。今回紹介したバス構成は立体音響の雛形としても活用できると思いますので、ぜひ試していただきたい ですね。

広瀬:

お試しいただく環境としては、Unity向けプラグインがAsset Storeで公開されていますし、UE5やWwiseに向けたプラグインもお問い合わせ頂ければ試用版をご提供可能です。また、「Sound xR Core遺跡探索デモ 」というフォトリアルな作品で立体音響を試せるデモコンテンツもご用意しています。ぜひ、一度音を聴いていただきたいです。

「Sound xR Core」製品紹介ページ 『METAL GEAR SOLID Δ: SNAKE EATER』公式サイト

ゲームメーカーズ編集長およびNINE GATES STUDIO代表。ライター/編集者として数多くのWEBメディアに携わり、インタビュー や作品メイキング解説 、その他技術的な記事を手掛けてきた。ゲーム業界ではコンポーザー/サウンドデザイナーとしても活動中。

ドラクエFFテイルズはもちろん、黄金の太陽やヴァルキリープロファイルなど往年のJ-RPG文化と、その文脈を受け継ぐ作品が好き。